ChatGPTの仕組み

ここでは生成AIがどのように動いているのかの仕組みついて解説していきます。

今回の記事は中・上級者向けの少し難しい内容になります。

GPTとは

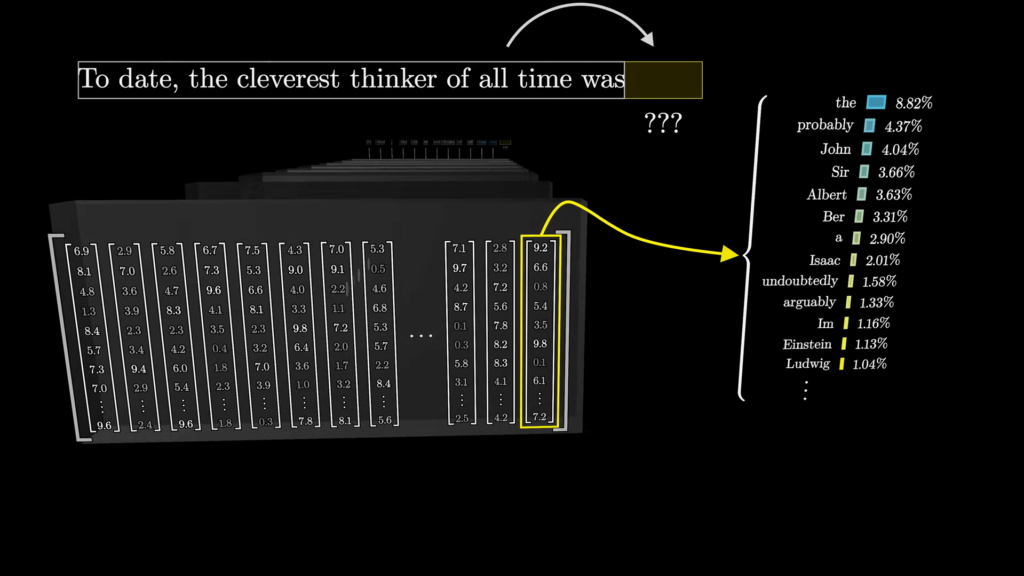

GPTとは、「Generative Pre-trained Transformer」の略であり、一言で表すならば、次に続く確率が高そうな単語を予測とサンプリング(確率分布)に基づいて出力する仕組みです。以下では、そのGPTの仕組みとそれに関連するワードを解説していきます。

Transformerとは

Transformerは、GPTを語る上で欠かすことのできない仕組みです。

現在の驚異的なAI進化のベースとなっている存在であり、ニューラルネットワークモデルの一つです。「処理が速い、精度も高い、汎用性も高くて何にでも使える」などとても優秀で、従来モデルが課題としていた「長期記憶や大規模データ処理」を容易にし、さらに並列処理までも可能としています。Transformerは、Attention(機構)を使うことでこのようなスペックを実現しています。

Attention(機構)とは

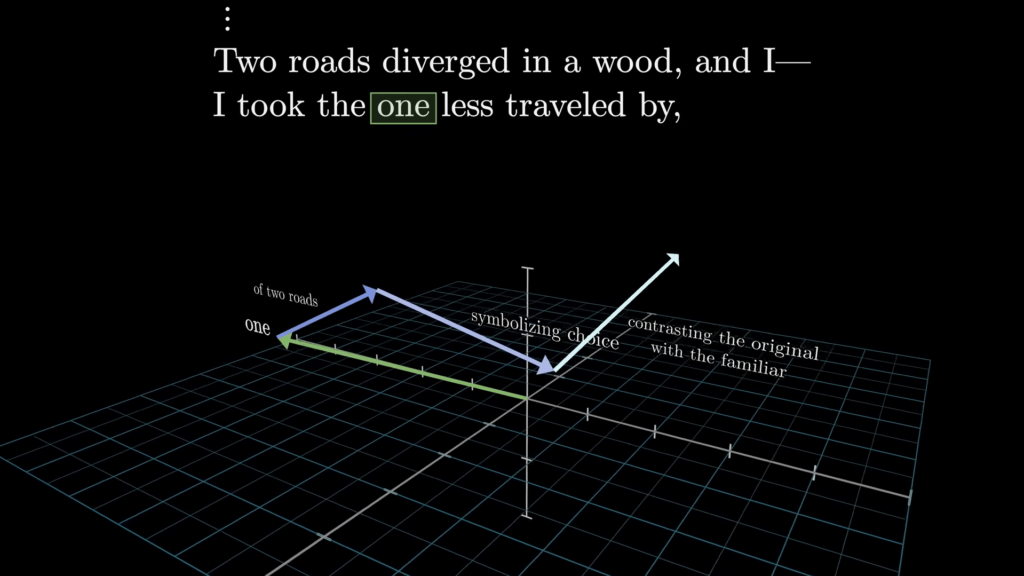

Attention機構とは、一言で表すと「入力されたデータのどこに注目すべきかを動的に特定する仕組み」です。どの部分が重要そうかを、数値で重みづけを行い特定します。

例えば、文章の中で「mole」という単語が出てきたとします。この単語は[モグラ、ほくろ、モル]と複数の意味を持っているので、その文章上でどのような意味合いを持つのかを探っていく必要があります。その際に、その単語以前の文章中に出てきた単語を参照し、この単語の意味に関連しそうな単語には高値を、関連しなさそうな単語には低値を付けていくことで、「mole」の意味を確率的に類推していきます。

ただし、Attention機構自体は単語の位置関係を認識できないため、埋め込み行列を用いて意味の推測を行います。

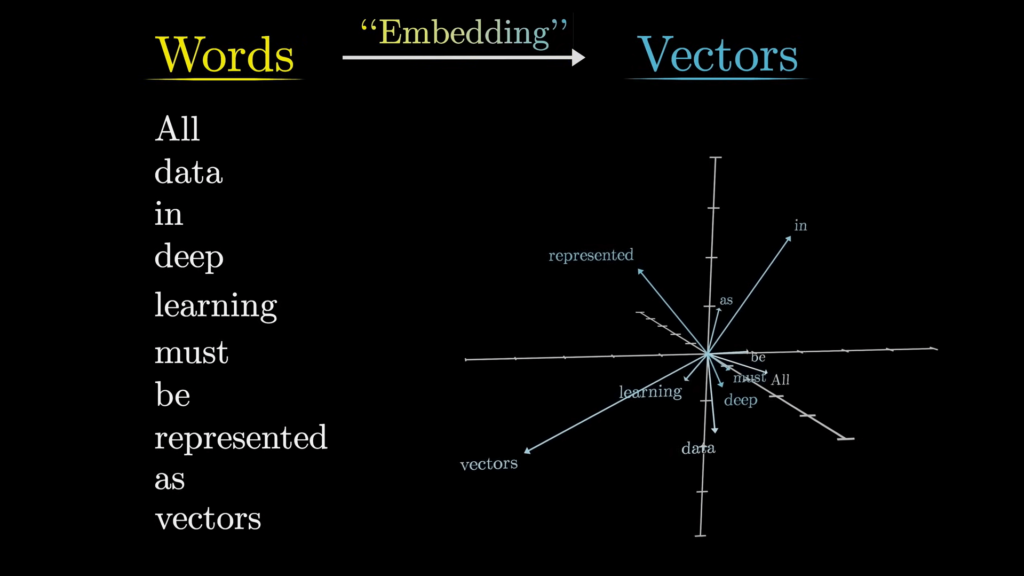

埋め込み行列とは

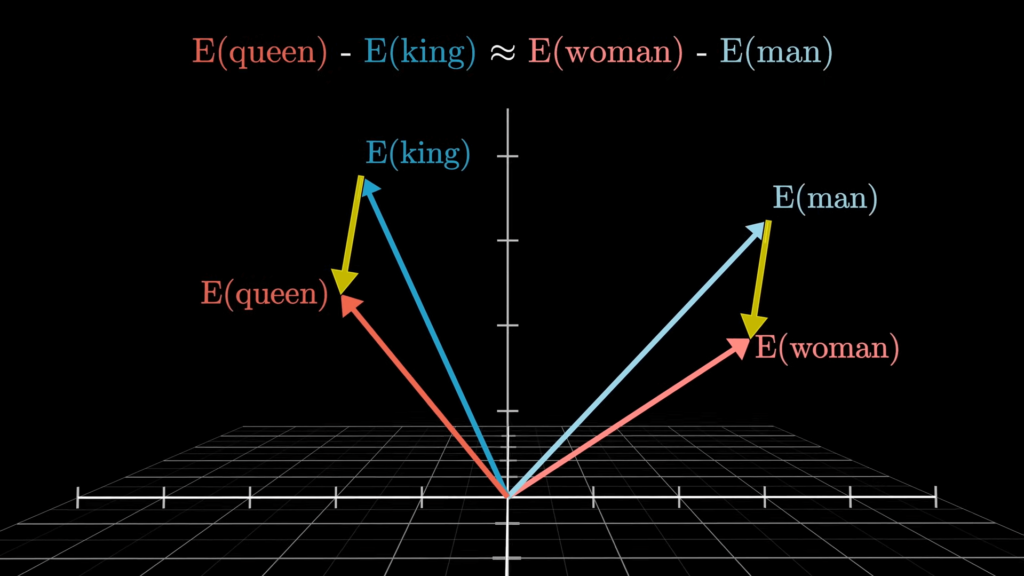

埋め込み行列とは、何万次元にも及ぶ空間上に単語を数値化して位置付け(ベクトル化し)たものです。この次元上では、2つの単語の内積(ベクトルの向き)が近い方向を向いていると“正”、垂直だと“0”、逆方向だと“負”を意味し、正であれば意味合いが近い単語で、負であればその逆となります。

さらに、この正負の度合いは、正であれば意味的に大きい(多い、長い)、負であれば意味的に小さい(少ない、短い)といったように相反する意味合いも持ちます。

このように単語を多次元上に埋め込んでいくことをEmbeddingといいいます。